KI-Betrug: Deepfakes werden zur Milliarden-Gefahr

25.01.2026 - 18:04:12Eine neue Welle raffinierter Betrugsmaschen, angetrieben von Künstlicher Intelligenz, verursacht erhebliche finanzielle Schäden und emotionales Leid. Besonders gefährdete Gruppen geraten zunehmend ins Visier der Kriminellen. Experten warnen: KI-gestützte Identitätsdiebstähle mit täuschend echten Videoanrufen und geklonten Stimmen werden 2026 massiv zunehmen.

Die perfekte Täuschung: So funktionieren KI-Scams

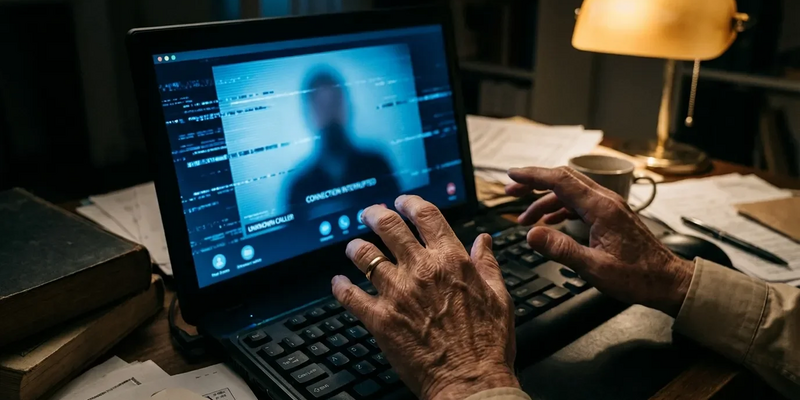

Im Zentrum der neuen Bedrohung steht Deepfake-Technologie. Sie erzeugt täuschend echte Videos oder Audiodateien von Personen. Betrüger sammeln dazu einfach Bilder und Videos aus sozialen Netzwerken. Schon drei Sekunden Original-Audio reichen oft aus, um eine Stimme täuschend echt zu klonen – inklusive Sprachmelodie und individueller Eigenheiten.

Diese Fälschungen setzen die Kriminellen in emotional manipulativen Szenarien ein. Eine besonders perfide Masche ist der „Enkeltrick 2.0“. Senioren erhalten verzweifelte Anrufe oder Video-Nachrichten von angeblichen Enkeln, die im Gefängnis, Krankenhaus oder in Geiselhaft sein sollen und dringend Geld brauchen. Der emotionale Schock überwiegt oft die Skepsis.

Viele Android-Nutzer unterschätzen, wie leicht Betrüger über WhatsApp- oder Zoom-Videoanrufe an persönliche Daten und Vertrauen gelangen. Ein kostenloses Sicherheitspaket erklärt die 5 wichtigsten Schutzmaßnahmen für Ihr Smartphone – von richtigen Privatsphäre‑Einstellungen über App‑Prüfungen bis zu Verhaltensregeln, die Deepfake-Scams sichtbar machen. So schützen Sie Ihre Chats, Fotos und Online‑Banking zuverlässig. Gratis-Sicherheitspaket für Android anfordern

Gefährdete Gruppen im Fadenkreuz der Betrüger

Während jeden treffen kann, zielen Kriminelle gezielt auf verwundbare Gruppen:

* Senioren sind wegen möglicher sozialer Isolation und geringerer Technikaffinität ein Hauptziel. Der finanzielle Schaden in dieser Gruppe geht bereits in die Milliarden.

* Migrantengemeinschaften werden mit angepassten Maschen betrogen. Die Täter geben sich als Einwanderungsbeamte oder Anwälte aus, nutzen die Verunsicherung im Behördendschungel und fordern Zahlungen für angebliche Hilfeleistungen – oft legitimiert durch Videoanrufe auf WhatsApp oder Zoom.

* Kleine Unternehmen erleben gefälschte Videoanrufe von angeblichen CEOs oder Lieferanten, die dringende Überweisungen oder geänderte Rechnungsdaten fordern.

Analyse: Warum die Bedrohung so schnell eskaliert

Die rasante Entwicklung und leichte Verfügbarkeit generativer KI macht die Gefahr so akut. Das World Economic Forum stuft KI-gestützten Identitätsdiebstahl als Top-Cyberbedrohung für 2026 ein. Die Sorge um KI-Sicherheit verdrängt damit frühere Top-Gefahren wie Ransomware. Eine aktuelle Umfrage zeigt: Fast drei Viertel der CEOs gaben an, 2025 selbst oder in ihrem Umfeld Opfer von Cyber-Betrug geworden zu sein.

Der psychologische Druck ist der Schlüssel zum Erfolg der Täter. Durch die Erzeugung einer Krisensituation – ein Angehöriger in Not, eine dringende Geschäftsanfrage – umgehen sie logische Überprüfungen. Die täuschende Echtheit der Deepfakes macht es noch schwerer: Die menschliche Erkennungsrate für hochwertige Fake-Videos ist alarmierend niedrig.

Schutzmaßnahmen: So wehren Sie sich ab

Cybersicherheitsexperten raten zu neuen Verifikationsgewohnheiten:

* Unabhängig verifizieren: Bei jeder dringenden, unerwarteten Geldbitte sofort auflegen und die Person über eine bekannte, vertrauenswürdige Nummer kontaktieren.

* Codewort vereinbaren: Familien sollten ein nur ihnen bekanntes Codewort festlegen, das in Notfällen abgefragt werden kann.

* Skepsis bei Dringlichkeit: Jede Aufforderung zu sofortigem, heimlichem Handeln ist höchst verdächtig. Betrüger nutzen Panik, um kritisches Denken auszuschalten.

* Soziale Medien absichern: Öffentlich geteilte Fotos und Videos sind Rohmaterial für Deepfakes. Privatsphäre-Einstellungen überprüfen.

Für Unternehmen werden Mehr-Augen-Prinzipien bei Finanztransaktionen und Schulungen zur Erkennung von Social-Engineering-Angriffen zur kritischen Sicherheitsmaßnahme. In der neuen Ära der KI-Bedrohungen sind wachsame Skepsis und proaktive Verifikation die wirksamste Verteidigung.