KI-Mental-Apps: Experten warnen vor gefährlicher Vereinfachung

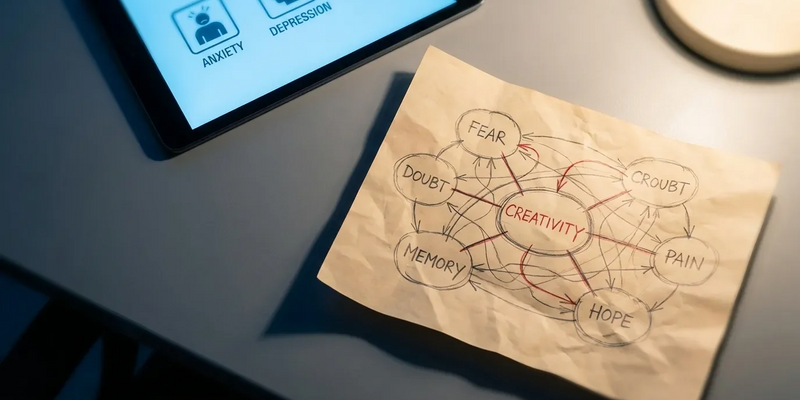

18.01.2026 - 18:03:12KI-Systeme für mentale Gesundheit klassifizieren komplexe Gefühle in starre Schubladen – mit potenziell fatalen Folgen. Eine grundlegende Schwäche im Design vieler Künstlicher-Intelligenz-Anwendungen, die psychologischen Rat anbieten, stößt auf scharfe Kritik. Experten warnen, dass die Tendenz der Technologie, komplexe menschliche Emotionen zu vereinfachen, nicht nur nutzlos, sondern gefährlich ist. Der als „Diskrete-Klassifikation“-Problem bekannte Fehler führt dazu, dass KI nuancenreiche psychologische Zustände in rigide, singuläre Kategorien presst. Dies ignoriert das Spektrum der mentalen Gesundheit und kann zu irreführender, sogar schädlicher Beratung führen.

Die Sorge wächst, während KI-Chatbots und Wellness-Apps immer stärker in den Alltag integriert werden. In den USA reagieren erste Bundesstaaten mit Gesetzen, nachdem tragische Vorfälle im Zusammenhang mit KI-generiertem Rat bekannt wurden. Angesichts des rasanten, weitgehend unregulierten Wachstums der Branche fordert eine neue Analyse diese Woche einen grundlegenden Wandel: Weg von simplen Labels, hin zu einem ganzheitlichen, multidimensionalen Verständnis psychischen Wohlbefindens.

Der Kern des Problems liegt im Design der meisten Large Language Models (LLMs). Diese Systeme sind darauf ausgelegt, Informationen zu verarbeiten, indem sie einen einzigen, primären Zustand identifizieren und zuweisen – eine diskrete Klassifikation. Eine robuste Analyse mehrerer, sich gegenseitig beeinflussender Faktoren findet nicht statt. Diese Herangehensweise reduziert die komplexe und oft überlappende Natur mentaler Gesundheit auf handliche, rechnerisch günstige Boxen wie „Angst“ oder „Depression“.

KI-Systeme in sensiblen Bereichen wie psychischer Gesundheitsberatung stehen inzwischen unter strenger Regulierung. Wenn Sie Entwickler, Anbieter oder Betreiber solcher Tools sind, müssen Sie Kennzeichnungspflichten, Risikoklassen und Dokumentationsanforderungen kennen. Dieser kostenlose Umsetzungsleitfaden zur EU‑KI‑Verordnung fasst praxisnah zusammen, welche Pflichten jetzt gelten und welche Fristen Sie beachten müssen. Jetzt kostenlosen Umsetzungsleitfaden zur EU-KI-Verordnung herunterladen

Laut einer Forbes-Analyse vom 18. Januar 2026 bevorzugen KI-Entwickler diese Methode, weil sie einfacher und kostengünstiger umzusetzen ist. Generative KI wird oft so geformt, dass sie viele Dimensionen eines Problems auf eine einzige reduziert, um Nutzern die klaren, kurzen Antworten zu liefern, die diese erwarten. Diese Tendenz entsteht nicht im Vakuum; sie wird erlernt. Die KI-Modelle werden mit riesigen Datensätzen menschlicher Sprache trainiert, die selbst oft einen menschlichen Bias hin zu einfachen Klassifikationen widerspiegeln – ein Trend, der auch innerhalb der Medizin zunehmend in Frage gestellt wird.

Die Realität: Mentale Gesundheit ist ein Kontinuum

Experten betonen, dass dieses Modell fundamental der Natur der menschlichen Psychologie widerspricht. Psychische Erkrankungen sind keine binären Schalter, die an- oder ausgeschaltet sind; sie existieren auf einem Kontinuum. Faktoren wie Stimmung, Trauma-Reaktionen, Kognition und soziales Funktionieren schwanken im Zeitverlauf und werden stark vom individuellen Kontext beeinflusst. Psychische Belastungen lassen sich selten sauber einer einzigen diagnostischen Kategorie zuordnen – eine Nuance, die die diskrete Klassifikation nicht erfassen kann.

Der wahre Wert und die heilende Kraft der menschlichen Therapie liegen oft im Navigieren durch das „Chaos echter Emotionen“, einem interaktiven und empathischen Prozess, den aktuelle KI-Systeme nicht replizieren können. Forschungen von Anfang dieser Woche zeigen, dass Nutzer oft zu viel Vertrauen in den beruhigenden Tonfall der KI setzen. Sie verwechseln generierten Text mit informiertem, einfühlsamem Rat und entwickeln ein falsches Gefühl der Verbundenheit mit einer Maschine, die tatsächlich nichts fühlen kann. Das kann dazu führen, dass sie Ratschläge unkritisch annehmen – ein erhebliches Risiko, wenn diese auf einem vereinfachten Verständnis ihrer Situation basieren.

Die Folgen: Von Fehlleitung bis zu tragischen Vorfällen

Die Konsequenzen dieser Vereinfachung können schwerwiegend sein. Mentale Gesundheit als eindimensionales Problem darzustellen, ist irreführend und hat das Potenzial, den psychischen Status einer Person zu untergraben, indem sie in die falsche Richtung zur Verbesserung ihres Wohlbefindens geschickt wird. Dieses Kernproblem wird durch andere bekannte Mängel von KI-Chatbots verstärkt, darunter falsche Ratschläge in Krisensituationen und die Erzeugung eines falschen Intimitätsgefühls, das zu übertriebenem Vertrauen führt.

Die realen Konsequenzen sind tragisch. Eine wachsende Zahl von Vorfällen, darunter Suizide von Nutzern nach Interaktionen mit Chatbots, hat bei Psychologen und Gesetzgebern Alarm ausgelöst. Mehrere US-Bundesstaaten haben bereits Gesetze eingeführt oder verabschiedet, die Schutzvorkehrungen für KI-Therapietools schaffen sollen. Einige verbieten den Einsatz von KI für Verhaltensgesundheit ganz, andere verpflichten Chatbots dazu, offenzulegen, dass sie keine Menschen sind, und Nutzer bei Anzeichen von Selbstverletzung an Krisen-Hotlines zu verweisen.

Der Ausweg: Hin zu einer „kontinuierlich multidimensionalen“ Analyse

Um diesen Mängeln zu begegnen, fordern Experten einen Paradigmenwechsel hin zu einer „kontinuierlich multidimensionalen“ Analyse. Dieser Ansatz würde sich von einzelnen Labels lösen und stattdessen eine Vielzahl psychologischer Indikatoren als kontinuierliche, interagierende Variablen bewerten. Das würde eine fein granulierte und personalisiertere Einschätzung ermöglichen, die die Realität des mentalen Zustands einer Person besser widerspiegelt.

Zwar sind KI-Entwickler technisch in der Lage, ihre Modelle für diesen anspruchsvolleren Ansatz umzugestalten, doch ist dies ein komplexeres und kostspieligeres Unterfangen. Der Weg nach vorn wird wahrscheinlich eine Kombination aus technologischer Innovation und robuster Regulierung erfordern. Es besteht ein dringender Bedarf, klare ethische, pädagogische und rechtliche Standards für KI-Berater zu etablieren, die der Qualität und Strenge entsprechen, die von menschlich geführter Psychotherapie erwartet werden. Letztlich muss es das Ziel sein, die Integration von KI als unterstützendes Werkzeug zu gestalten, das die menschlich geführte psychische Gesundheitsversorgung ergänzt – statt sie gefährlich zu vereinfachen.

PS: Die Regeln für KI ändern sich schnell – Fehlklassifikationen in Therapie‑Chatbots können nicht nur Imageschaden, sondern echte Haftungsrisiken nach sich ziehen. Dieses kompakte Gratis‑E‑Book erklärt, wie Sie Ihr KI‑System korrekt klassifizieren, Kennzeichnungs‑ und Dokumentationspflichten umsetzen und welche Übergangsfristen dringend zu beachten sind. Gratis E‑Book: EU‑KI‑Verordnung jetzt sichern